虚拟现实(VR)眼镜就是一个例子。VR 眼镜能让用户沉浸在一个人造的三维世界中,体验电脑游戏和 360 度视频,就如同在实际行动中一样。例如,一个针对幼儿园孩子的实验表明,这种体验能像真事一样被记住,而不是像 VR 模拟。但是,这对于专业应用也是很有用处的:例如,机器、系统或工厂的规划数据可以在虚拟现实中实现。有了某些 VR 眼镜,智能手机被插入固定座中,并当作显示器使用。手机或眼镜上的传感器检测到佩戴者的头部动作,使他们就能在虚拟世界中环顾四周。

技术和计算机系统在日常生活和产业中承担着台前或幕后的重要任务。传感器和接口使之得以运行。但是用户和计算机之间如何进行通信并相互做出响应呢?机器可以通过触摸、语音、手势或虚拟现实(VR)眼镜进行控制。

我们早已习惯了人机交互:智能手机用户向数字助手询问天气状况,后者给予答复。在家里,人声控制智能温控器,或者指挥 Amazon 的智能扬声器 Echo 播放“69 年的夏天”。智能手机触摸屏上的一些手势足以用来查看来自肯尼亚的照片并将单张照片放大。聊天机器人自动与信使中的客户进行对话。业界的工程师使用 VR 眼镜,使其能在规划中的工厂建筑物中行走。尽管可能,但你仍需要进行人机交互(HMI)。

人机界面就是关于人和自动化系统之间是如何进行互动和交流的。这早已不再仅仅局限于工业中的传统机器,如今还涉及到物联网(IoT)中的计算机、数字系统或设备。有越来越多的设备连接起来并开始自动执行任务。操作所有此类机器、系统和设备需要直观显示出来,不能对用户提出过高的要求。

人与机器之间的沟通顺畅需要用到接口:用户与机器互动的地方或所需的动作。简单的例子就是车灯开关或踏板和方向盘:当您敲击开关、转动方向盘或踩下踏板时就会触发一个操作。但是,也可以通过键入文本、使用鼠标、触摸屏、语音或手势来控制系统。

设备可以直接进行控制:用户触摸智能手机的屏幕或发出一个口头命令。或者,系统自动识别出人们想要的东西:当车辆驶过路面的感应回路时,交通灯会自行改变颜色。其他技术并非都是用来控制设备的,而是用来对我们的感官加以补充。虚拟现实眼镜就是一个例子。还有数字助手:例如,聊天机器人会自动回复客户的请求并能不断地学习。

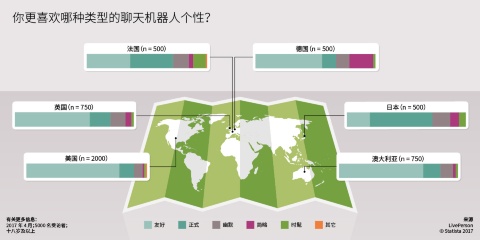

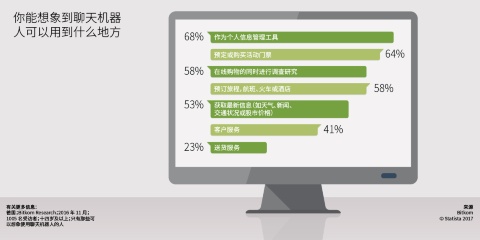

第一个聊天机器人 Eliza 是在二十世纪六十年代发明的,但很快就遭遇其局限性:它不能回答后续的问题。现在情况不一样了比如,如今的聊天机器人“从事”客户服务并就出发时间或服务给出书面或口头信息。要做到这一点,它们对关键字做出响应,检查用户的输入,并依赖预先编程的规则和例程做出答复。现代的聊天机器人则采用人工智能。像亚马逊的 Alexa 和 Google Home 或 Google Assistant 之类的数字助手也属于聊天机器人。

机器人从这些要求中进行学习,从而自行扩展其指令系统,而无需人类直接干预。机器人能记得之前的谈话,建立联系并能扩大其词汇量。例如,Google 的语音助手能借助人工智能从其语境中推断出查询结果。聊天机器人理解力越强,反应能力越好,我们就越接近如同两个人之间的谈话沟通的境界。大数据 在这里也扮演了一个角色:如果有更多的信息可以输送给机器人,且它们可以更为具体的方式作出响应,并给出更为适当的答复。

聊天机器人和数字助手的重要性将不断地增加。据市场调查公司 IHS 预测,未来几年,仅助手(如亚马逊的智能扬声器 Echo)一项就有 46% 的增长率。

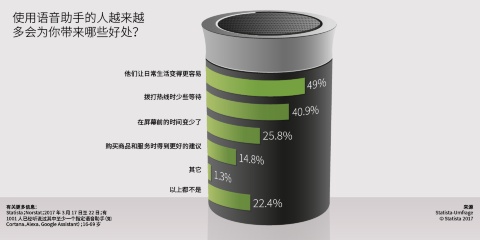

用户通过其语音来控制诸如 Alexa、Google Assistant、Google Home 或 Microsoft 的 Cortana 之类的系统。他们不再需要触摸显示屏 - 他们只需要说出字码(如“Alexa”)来激活助手,然后再输入“降低音量”或“降低卧室温度”之类的话即可。这对于用户来说就不那么费力,而且更直观。早在 2014 年,微软首席执行官 Satya Nadella 就预言:“人声就是新的接口”。

然而,语音识别仍然不那么完美。由于背景噪音的干扰,助手并不能理解每一项请求。又比如,它们经常无法区分人声与电视之间的差别。据美国消费者技术协会(CTA)的数据,2013 年的语音识别错误率为 23%。2016 年,微软的研究人员首次将这一数字降至 6% 以下。但是这还不够。

英飞凌计划与英国的半导体制造商 XMOS 携手,以大幅改善语音控制功能。该公司为物联网中的设备提供语音处理模块。英飞凌和 XMOS 于 2017 年初提出的新解决方案采用了智能麦克风。它使助手能在其他噪音当中识别定位人声:英飞凌的 XENSIV™ 雷达和硅麦克风传感器的组合能识别扬声器与麦克风的位置和距离,并利用 XMOS 的远场语音处理技术 来捕捉语音。

英飞凌电源管理及多元化事业部总裁 Andreas Urschitz 表示:“我们能更好地抑制背景噪声,从而能够大大提高语音识别能力和准确率。”语音控制因此被“提升到一个新的高度”。例如,Urschitz 认为,未来通过语音来操作智能电视将会变得越来越重要。到 2022 年,该市场可能增长到 6000 万台带内置声控功能的电视机,增加了 5 倍之多。

Andreas Urschitz 也看到了智能家电所发生的重大变化。例如,Robovacs 现在可通过触摸屏进行操作。但这不切实际,因为用户必须走到设备旁才能停止它们。“我认为这种设备将在未来采用语音控制系统。”然而,按照他的观点,即使通过语音命令来操作它们也是一个中间步骤。从长远来看,我们将通过手势来控制设备。一个手势就足以让机器人停下来。“但这只是下一步,”Urschitz 说。“首先我们要与 XMOS 合作,让语音控制更高效。”

与触摸屏相比,手势控制具有以下多种优点:例如,用户不必触摸设备就可以从远处发出命令。手势控制是语音控制的替代方案,尤其是在公共区域。毕竟,在地铁上用智能可穿戴式设备讲话对某些人来说可能会有些不舒服,并引起不必要的关注。手势控制还打开了第三维,远离了二维用户界面。

Google 和英飞凌开发了一款名为“Soli”的新型手势控制器。他们对其采用雷达技术:英飞凌的雷达芯片可以接收用户手指反射出来的波。这意味着如果有人动一下他的手,其便可通过芯片进行注册。接着,谷歌算法开始处理这些信号。该算法甚至可以在黑暗中、远程或用肮脏的手指进行操作。所有的 Soli 设备都采用相同的统一手动动作。Soli 芯片可在所有可能的设备,如扬声器或智能手表上使用。Andreas Urschitz 说:“追踪动作和触摸模式的成熟算法,以及微型高度集成的雷达芯片,都可以实现大范围的应用。”这项技术未来可能使所有的按钮和开关成为多余。

现代的人机交互一直以来并不仅仅是移动操纵杆或按下按钮。增强现实的技术也可以是人与机器之间的接口。

虚拟现实(VR)眼镜就是一个例子。VR 眼镜能让用户沉浸在一个人造的三维世界中,体验电脑游戏和 360 度视频,就如同在实际行动中一样。例如,一个针对幼儿园孩子的实验表明,这种体验能像真事一样被记住,而不是像 VR 模拟。但是,这对于专业应用也是很有用处的:例如,机器、系统或工厂的规划数据可以在虚拟现实中实现。有了某些 VR 眼镜,智能手机被插入固定座中,并当作显示器使用。手机或眼镜上的传感器检测到佩戴者的头部动作,使他们就能在虚拟世界中环顾四周。

通过增强现实(AR)眼镜,尽管额外的虚拟元素也被投射到其中,但真实的环境仍可保留在用户的视野中。智能手机游戏 Pokémon Go 证明了这两种元素的混合体可以做得多么成功。不同的图形根据用户移动显示器时所处的位置来显示。

像 Microsoft HoloLens 之类的混合现实(MR)眼镜则更进了一步,将虚拟与增强现实联系在一起。HoloLens 是一个独立的电脑,可以在现实空间里精确地定位三维物体。这种眼镜是通过手势和语音命令来控制的。混合现实眼镜由于其较高的分辨率,能逼真地呈现各种场景。

虚拟、增强和混合现实不仅用于娱乐和游戏,还能用于工业 4.0。例如,Microsoft HoloLens 的应用程序能为技术人员提供虚拟培训课程。弗劳恩霍夫工厂运行与自动化研究所(IFF)将混合现实实验室 Elbedome 租给了企业。他们可以使用六台激光投影仪在 360 度表面上显示机器、工厂或整个城市,使开发者或客户能有一种正好站在所规划工厂里的印象。

英飞凌的 3D 图像传感器芯片 REAL3™ 可对环境进行三维高质量的描绘。它安装在诸如华硕和联想的一些智能手机之类的移动设备中。这里运用到了时间飞逝原则:图像传感器芯片能测量出红外光信号从照相机传输到物体并返回所需的时间。这些设备因此能直接访问增强现实:其通过运动跟踪来检测位置的变化,而物体的距离则是通过深度感知来测量的。空间学习可确保设备能识别其已捕获过的地方。

由于现代化的人机交互,即使是复杂的系统也会变得更易于使用。要做到这一点,机器将越来越适应人类的习惯和需求。虚拟现实、增强现实和混合现实也将使之能接受遥控。结果是,人类得以扩大其经验领域和行动领域。

机器将来还会继续在解释信号方面做得更好 - 这也是必需的:全 自动驾驶的汽车 必须对来自交叉路口交警的手势信号做出正确的响应。用于护理的机器人同样也必须能够“评估”无法表达这些感受的人的需求。

机器所做的贡献越是复杂,它们与用户之间进行高效的沟通就变得越为重要。该技术是否也能理解命令所表达的含义?如果不能,就会存在误解的风险 - 系统将不能正常工作。结果:例如,机器生产出不合适的零件,或者所连接的汽车在道路上跑偏。

在接口和传感器的开发中必须始终将人的能力和局限性考虑进去。操作机器不能过于复杂或需要太多的熟悉过程。人与机器之间的顺畅沟通也要求命令与行动之间的响应时间要尽可能地短,否则用户不会认为这种交互是自然的。

机器要高度依赖传感器才能得到控制或自动进行响应这一事实构成了一个潜在的风险。如果黑客能够访问到这些数据,他们就能获得用户行为和兴趣的细节。一些批评者也担心,学习机器可能会自主行事,并征服人类。到目前为止还没有澄清的一个问题是,谁需对人机交互错误而引起的事故承担责任,且谁来对之负责。

人机交互远未到达语音和手势控制以及虚拟、增强和混合现实的终点。将来会有越来越多来自不同传感器的数据被结合起来,用于捕捉和控制复杂的进程(传感器融合)。

同时,目前常用的输入设备,如遥控器、电脑键盘或通/断开关等也会变得越来越少。如果计算机系统、设备和机器不断学习并获得更多的数据,它们也将变得越来越像人类:然后它们可以将感官的任务接过去。摄像头可以让它们看,麦克风可以让它们听,而配有传感器的衣服可以传达触感。正如 Andreas Urschitz 解释的那样,英飞凌正在传感器的帮助下越来越好地复制人类的感觉:“气体传感器将能“嗅闻”,传感器可以解读气压,3D 相机增强了设备的“视力”。

机器将能借助传感器来分析其周围正在发生的事情。结果是产生全新的交互形式。Urschitz 举了一个例子:带有气体传感器的手机能“闻到”附近正在烘烤的汉堡包。然后,数字助手建议查看菜单,因为某种汉堡包目前正在出炉。同时,有了面向感知的传感器,设备还可以对用户的身体语言做出解释和响应。

人工智能使机器变得越来越智能化。在机器学习中,计算机自己就能从数据中推断出结果。如今,这已经是可能的了,如亚马逊的 Alexa 这样的数字助手即是明证。但是,如果该技术能在更短的时间内处理越来越多的数据,则机器自己的“思考”能力也会提高。

更新于:2018 年1月