量子コンピューターとは

簡単に言うと、量子コンピューターとは量子力学の法則を使って演算するプロセッサのことです。つまり、量子力学の影響が非常に大きい極小の粒子 (原子や分子など) の振る舞いを非常に正確に再現するということです。量子力学は日常生活にまつわるさまざまな疑問にも答えてくれます。量子コンピューターの動作方式は電子の状態が明確に規定される古典コンピューターと異なります。量子コンピューターは確率によって定義される量子状態の相互依存性を利用します。量子コンピューティングを理解する際、「量子もつれ (量子エンタングルメント) 」と「重ね合わせの原理」という2つの物理法則または状態が重要になります。最先端のプロセッサを搭載した古典コンピューターとスーパーコンピューターに限界がある一方、量子コンピューターは非常に強力な演算能力を備えているため、これまで解決できなかったタスクの新たなソリューションになります。

量子コンピューターのしくみ

量子コンピューターの機能を説明する前に、まず古典コンピューターがデータをどのように演算するか見てみましょう。古典コンピューターでは演算が順次、直線的に行われます。たとえば、複数の場所に移動する際、所要時間が最も短かい最適経路を探索するとします。これは「巡回セールスマン問題」と呼ばれており、物流や経路探索で重要な問題です。最適ルートを判定するため、コンピューターはすべての経路を順次シミュレーションし、さまざまな要素を考慮に入れて演算した結果、1つの経路を提示します。

量子コンピューターはこの演算をどのように処理するのでしょうか。簡単に言うと、複数の古典コンピューターを同時に動かすような演算をします。量子プロセッサは1つの演算ではなく、複数の演算を並行処理し、その結果に基づいて最適なルートを短時間で判定することができるのです。どのようにそれを実現するのでしょうか。量子コンピューターは古典ビット (バイナリ ビット) ではなく量子ビット (キュービット) を情報の最小単位として演算します。現在のコンピューターがデータを順番に検索、処理するのと異なり、量子コンピューターは量子ビットの特性を利用して同時にそれを実行します。マルチタスクという観点では、まさに奇跡と言えます。量子ビットを1つ増やすごとに指数関数的にマルチタスク可能な処理が増えるからです。

量子ビットとは

量子ビット (キュービット) は古典ビットの量子力学版ともいえるもので、量子コンピューターにおける演算の基本単位となっています。古典ビットは電子回路内の電荷の状態に基づいていますが、量子コンピューティングでは今のところ、さまざまな種類の量子ビットが使われます。量子ビットには原子、イオン、電子、さらには光子も使われ、それぞれ別の材料システムが用意されます。特殊なケースでは超伝導などの効果を利用して目的の特性を得ることもあります。

古典ビットと異なり、量子ビットは2つの値または状態を同時に持つことができます。バイナリ系の古典ビットが0または1のどちらかの状態しか保持できないのに対し、量子ビットは一定時間、両方の状態を保持できるのです。量子コンピューターには非常に大きな優位点があります。それは1つの演算ステップによって既存の全ての状態に同時に影響を与えることができる点です。1つの量子ビットで複数の演算を同時に行うことができるため、非常に強力な演算性能が実現します。しかも、それを指数関数的に高めることも可能です。量子ビットは適用可能な問題が限られており、一部の問題には使用できません。それでも、理論計算で従来ビットと比較した場合の勝者は明らかです。量子コンピューターの勝因は「量子もつれ」と「重ね合わせ」という、量子力学における2つの原理にあります。

量子もつれとは

1つ目の原理「量子もつれ」とは量子ビット同士が相互関係、すなわち「もつれ」関係を持つことができることです。たとえば、2つの量子ビットが磁界の中に入り、互いの挙動に影響を与える特殊な相互依存性が生まれたとしましょう。両者はある意味、非常に固く結ばれており、場合によってはその関係は両者の距離に依存しません。そのため、1つの量子ビットが変化したら、もつれ関係にあるもう1つの量子ビットもそれに応じて即座に、距離に関係なく変化します。これは本当に驚くべき規則性です。

量子もつれをわかりやすく簡単に説明してみましょう。月面にある1つの量子ビットの状態を変えたら、もつれ関係にある地球上のすべての量子ビットが同時にその影響を受けます。もう1つ、古典的な豆隠しゲームの例で簡単に説明しましょう。ただし、貝の数は2つのみです。観測者の私たちは豆がどの貝の下に隠されているのか知らされていません。この時点で、それぞれの貝は「豆がある」と「豆がない」という2つの状態があり得ます。1つの貝をひっくり返したときに、初めて中の状態がわかります。それと同時にもう1つの貝の中の状態も知ることができます。それぞれの貝を別の部屋に置いた場合も同様です。この古典ゲームでは貝をひっくり返す前に豆がすでにどちらかの貝の下に置かれています。驚くべきことに、量子力学ではそれが通用しません。豆の場所はどちらかの貝がひっくり返される瞬間まで決定しないのです。

量子もつれは量子コンピューターの演算能力にも影響を与えます。なぜなら、使用する量子ビットの数が増えれば演算能力が増大するからです。もつれ関係にある量子ビットの数が増えるほど、演算と処理を同時に行える状態の数も増えます。量子コンピューターでは原則的に、2つのもつれ関係にある量子ビットに複数回の操作をすることで、あらゆる演算が可能です。ただし、そのためには部分的に演算ステップが大幅に増える場合があります。もつれ関係を使うと、量子が制御可能になるのでアルゴリズムを使った演算が可能になります。もしすべての量子ビットが完全に互いに独立していれば、演算は不可能です。この場合は古典コンピューターと同様です。2つの数を追加してもそれが反映されないなら、演算したことになりません。量子ビットも同様です。挙動が相互依存しているからこそ、特定の演算が可能なのです。

重ね合わせとは

量子コンピューターの2つ目の基本原理が「重ね合わせ」です。重ね合わせとは2つ以上の状態が同時に一定時間 (コヒーレンス時間) 持続する量子ビットの特性を指します。量子力学的コヒーレンス時間は数ミリ秒から1時間以上までさまざまで、その時間が経過すると重ね合わせ (と量子もつれ) が失われます (デコヒーレンス)。量子ビットの数が1つの場合は重ね合わせの効果があまりありませんが、数が増えると大きな効果を発揮します。2つの量子ビットなら、保持できる状態の数が4つになります。10個なら1000以上、20個なら100万以上に膨れ上がります。量子ビットが1つ増えるたびに、システム内に保持できる情報量が倍増するためです。量子コンピューターに数十の量子ビットを持たせれば、最も能力の高い古典コンピューターのストレージ容量をも上回ります。これらすべての状態で同時に演算できる「量子もつれ」を組み合わせると、非常に効率の高いシステムになります。

ここまでの説明で、冒頭に紹介した2つの問い「重ね合わせと動作方式の関係」と「量子コンピューターがこの記事を一瞬にして読み終える理由」への解答が示されました。理論上、量子コンピューターは「重ね合わせ」により、この記事のすべてのパラグラフを同時に解析しつつ結論を出すことができるのです。もう1つ、重ね合わせの例を紹介しましょう。量子コンピューターを使って宝くじを引くとします。通常、1 等を狙うには大量のチケットを購入しなければなりません (確率は1億4000万枚に1枚)。しかし量子コンピューターなら運任せにする必要がありません。1枚のチケットを購入するだけで、6桁の当選番号が手に入るのです。まるで魔法のように、封筒からチケットを取り出すたびに当選しているのです。まさに宝くじの天才です。重ね合わせの原理には多くの分野で非常に大きな可能性があるため、冒頭で触れたように高効率の量子コンピューターの開発をめぐって世界規模のレースが繰り広げられています。

量子コンピューターの過去、現在、未来

今あなたがこの記事を読むのに使っているデバイス内の演算装置も、かつて数十年にわたって理論上の仮定に過ぎませんでした。そして今もなお、効率の良いコンピューターの開発レースが世界各国で進行しています。今日の量子コンピューターをめぐる状況もそれに似ています。初期段階こそ順調ですが、本格的な普及には長い年月が必要でしょう。さて、未来の量子コンピューターはかつての古典コンピューターのように、予想以上のスピードで世界的に普及するのでしょうか。すでに理論の段階を突破した量子コンピューターは存在するのでしょうか。それでは、量子コンピューターの歴史をひもといてみましょう。

量子力学をコンピューターに応用しようというアイデアが示されたのは1950年代後半でした。以降、数十年にわたり、多くの科学者によって研究が進められています。まず紹介するのは、有名なドイツの物理学者です。彼は量子論の発展に大きな役割を果たしました。

| 1935年: ドイツの物理学者アルバート アインシュタイン、米国の物理学者ボリス ポドリスキー、米国出身のイスラエル人物理学者のネイサン ローゼンが科学論文「Can quantum-mechanical description of physical reality be considered complete? (物理的実在の量子力学的記述は完全だとみなせるか?)」で量子力学的世界の概念に疑問を投げかけました。ただし、その仮定は後年、誤りであることが判明しました。 |

| 1959年: 米国の物理学者でノーベル賞受賞者のリチャード ファインマンがカリフォルニア工科大学で微小な世界におけるテクノロジーの応用について講演を行いました。 |

| 1980年: 米国の物理学者にして量子情報理論の先駆者であるポール ベニオフが量子コンピューターの基礎となる初の理論的根拠を提示しました。 |

| 1985年: イスラエル生まれの英国の量子情報理論物理学者、デイヴィッド ドイッチュがオックスフォード大学で量子論で従来型コンピューターを再現するモデルを提唱しました。それにより、普遍的に使用可能な量子コンピューターの概念が誕生しました。 |

| 1994年: 米国の数学者 コンピューター科学者ピーター ショアが素因数分解を可能にする画期的な「ショアのアルゴリズム」を提唱しました。このアルゴリズムにより、量子コンピューターを使用した複雑な暗号の効率的な解読が理論上可能になりました。 |

| 1995年: オーストリアの理論物理学者ペーター ツォラーとスペインの物理学者イグナシオ シラクが冷イオンを使用した量子コンピューターを提唱しました。同年、この理論に基づいた初の演算がクリストファー モンローと米国NIST (米国国立標準技術研究所) 科学者グループによって行われました。 |

| 1998年: 英国の物理学者ジョナサン A ジョーンズとカナダの数学者ミシェル モスカがオックスフォード大学で2つの量子ビットを使用した初の量子コンピューターを提示しました。2つの量子ビットがさまざまなメリットをもたらし、リチャード ファインマンが1959年に初めて提唱した理論的概念が具現化しました。 |

| 1999年: IBMがカリフォルニア州のアルマデン研究センターで3つの量子ビットを使用した初の量子コンピューターを発表したため、前年に2つだった量子ビットが1年後に3つまで増えました。 |

| 2000年: ミュンヘン工科大学で5量子ビットが機能する初のコンピューターのデモンストレーションが行われました。 |

| 2005年: オーストリアの物理学者ライナー ブラット率いるワーキンググループにより、インスブルック大学で8個の量子ビットを使用した初の量子コンピューターが誕生しました。5年間で次のレベルに到達したことになります。 |

| 2006年: 量子コンピューティング研究所、MIT、ペリメーター理論物理学研究所により、12量子ビットの量子コンピューターが誕生し、開発がさらに加速しました。 |

| 2010年: ドイツ中西部のマインツにあるヨハネス グーテンベルク大学のアルノ ラウシェンボイテル博士率いる物理学者グループにより、量子情報の伝達に適した光と原子の間で光ファイバーを使用した量子インタフェースが実現しました。 |

| 2017年: 量子ビットの数をめぐるレースはますますスピードが上がっていきました。IBMは17量子ビットの実働量子コンピューターを公開し、同年、50量子ビットの開発を発表しました。 |

| 2018年: 開発競争にGoogleが加わって72量子ビットでブレークスルーを果たしたことで、Googleの研究者のジュリアン ケリーは「量子超越性」 (量子コンピューターが複雑な問題を解く能力において従来型のスーパーコンピューターを凌駕するという意味) を言及しました。今回発表した量子コンピューターによってそれが実現した可能性がありますが、その時点では証明されませんでした。 |

同じ年、量子コンピューティング先駆者のライナー ブラット、ペーター ツォラーらがインスブルックでスタートアップ企業「Alpine Quantum Technologies」を創業しました。目標はイオン トラップ型量子コンピューターの実用化です。

また、フィンランドのスタートアップ企業「IQM」が超伝導プラットフォームをリリースしました。現在、IQMはこの分野で最も投資を獲得している欧州企業になっています。

| 2019年: ラスベガスで開催されたCESテクノロジー フェアで、IBMが20量子ビットの「Q System One」を発表しました。将来的にデータセンターからクラウド アプリケーションとして提供される初の量子コンピューター システムです。さらに、冷却装置や制御装置など必要なコンポーネントがすべて1つのデバイスに組み込まれた、初の統合システムが発表されました。 |

同年、Googleの研究者が新たなマイルストーンを打ち立てました。53量子ビットを持つ新しいチップ「Sycamore」で複雑な乱数を発生させ、古典コンピューターに対する量子コンピューターの優位性、すなわち「量子超越性」を実証したと主張しました。Sycamoreはこのタスクを3分20秒で完了しました。最も効率的なスタートアップ企業でも約1万年かかるとされています。ただし、現時点ではあくまでフィージビリティ スタディであり、実用に適した演算能力は示されていません。

| 2021年: ドイツのシュトゥットガルト近郊のエーニンゲンで、IBMがフラウンホーファー研究機構と共同で初の商用量子コンピューター システムの運用を開始しました。このシステムにより、新しいテクノロジーの具体的なアプリケーションに向けた研究の推進が期待されます。 |

とはいえ、このテクノロジーはまだ黎明期にあり、まだ個人が量子コンピューターを購入できる段階に達していません。しかし、クラウド システム経由で量子コンピューターにアクセスする方法が用意されており、簡単な問題なら無料で使用することも可能です。多くのことが未定ですが、次のデジタル産業革命をめぐるレースは数年にわたって白熱しており、ドイツも開発レースに参加しています。そうした目的を達成するため、アンゲラ メルケル首相率いるドイツ政府は2021年に20億ユーロを投資すると発表しました。さらに、2026年までに500量子ビットに拡張可能な100個以上の制御可能な量子ビットを持つ国産の量子コンピューターを製造するという明確な目標を設定しています。スーパーコンピューター開発が徐々に物理的な限界に達しようとしている中、将来に備えた賢明な基礎作りといえるでしょう。また、ドイツはすでに光量子センサー、レーザー、実験機器など量子技術製品を提供する国際的に重要なサプライヤーとなっています。

実用化に向けた現実的な方法としては、通常のコンピューターと量子コンピューターを組み合わせて実用化のハードルを下げることも考えられます。カナダの企業D-Waveはその方向ですでに数年にわたって動いています。特定の演算にはいわゆる量子アニーリング型 (機能が限定されている量子コンピューター) を用い、残りの演算には古典コンピューターに任せるという手法です。フォルクスワーゲンはすでに1,135個の量子ビットを含むハイブリッド コンピューターを使用して、最適な交通制御に使用可能なナビゲーションシステムなどを試験しています。

遅かれ早かれ、量子コンピューターはその特性が医薬品、新素材、高度な物流、金融プロセス、人工知能、機械学習などの開発に活かされ、将来を形作っていくことになるでしょう。

量子コンピューターのアプリケーションと優位点

消費電力の低さと並行処理が特長の量子コンピューターは膨大な量のデータを極めて高速かつ効率的に処理することが可能です。Googleとその量子コンピューター「Sycamore」の実験により、その優位性 (量子超越性) が2019年に証明されました。最も強力なスーパーコンピューターで約1万年かかる演算を、53量子ビットのコンピューターならわずか3分20秒で完了しました。

量子コンピューターとその優位点が重要になる分野は主に以下の5つです。

| 1. 物流と運輸プロセスの最適化。リアルタイムで最適な選択肢が演算可能に。 |

| 2. 医薬品とワクチンの開発。演算の効率化により、時間のかかる実験が促進され、分子モデルの再現度が向上。 |

| 3. 新素材のシミュレーションと開発。特定の物性と信頼性の高い予測が事前に計算可能に。 |

| 4. 天気予報。さまざまな要素を考慮することで精度が向上。 |

| 5. 人工知能と機械学習。膨大な量のデータから異常値やパターンを見つけ出す能力が重要に。 |

特に科学分野において、量子コンピューターの性能は現代のコンピューターやスーパーコンピューターが到達し得ない非常に大きな可能性を秘めています。

量子コンピューターと古典コンピューターの違い

量子コンピューターと古典コンピューターの主な違いはデータの演算方法にあります。古典コンピューターは演算の最小単位としてビットを使用し、量子コンピューターは量子ビット (キュービット) を使用します。量子ビットは古典ビットと異なり、複数の状態を同時に保持できるため、特定の問題に対してはるかに強力な演算が可能です。しかも、量子コンピューターは量子ビットを増やすことで演算能力が指数関数的に増大します。

それならば、量子コンピューターは古典コンピューターよりも優れていると言えるのでしょうか。演算能力のみが重要で、さまざまなコンピューティングが考えられる中でアプリケーションを限定してもよいのであれば、答えはイエスです。しかし、日常的な操作性を考慮すると、量子コンピューターの優位性はあくまで理論上にとどまります。なぜなら、現在のコンピューターがそれぞれの用途で実用的な量子コンピューターに置き換わる時が来るまでは飛躍的な技術的発展が必要だからです。スーパーコンピューターに対する競争力という点で、量子コンピューターが最もスピーディかつ重要な進化を遂げている分野は科学や研究関連でしょう。他の多くの分野では古典コンピューターのアーキテクチャーのほうがベターな選択肢でありつづけます。今後、量子コンピューターは古典コンピューターを駆逐するのではなく、補完する存在になるでしょう。

量子コンピューターとスーパーコンピューターの違い

未来の量子コンピューターの潜在的なアプリケーションは大部分において、現代のスーパーコンピューターのそれと重なります。つまり、自然科学における複雑なシミュレーションの計算です。スーパーコンピューターは通常のコンピューターのような演算手法を取りますが、単一のコンピューターとは異なり、相互接続された大規模システムで演算します。そのようなシステムは多数の演算コア、すなわちコンピューターで構成されています。汎用の演算タスク用の CPU (Central Processing Unit) コンポーネント、GPU (Graphical Processing Unit) コンポーネントの他に、計算処理ユニット当たりの消費電力を低減するアクセラレーターが含まれます。

つまり、スーパーコンピューターの演算手法は複数のコンピューターによる膨大な数の同時計算をベースとしているのです。スーパーコンピューターが量子コンピューターと決定的に異なるのは一度に1つのシステムのみを使用して同時計算を行う点です。

それならば、量子コンピューターとスーパーコンピューターの戦いは前者の勝ちということになるでしょうか。コンピューターと比較した時と同様、その優位性は理論上、特定分野に限定されます。なぜなら、量子コンピューターがスーパーコンピューターを完全に凌駕した具体的なアプリケーションがまだ存在しないからです。Googleのタスクを例にとると所要時間が量子コンピューターではわずか3分20秒だったのに対し、スーパーコンピューターでは推定1万年でしたが、客観的に見ると量子コンピューターの演算手法に適した「ホームゲームの有利さ」がこの結果につながりました。Googleのソリューションは実際のアプリケーション面よりも実現可能性を示すデモンストレーションの側面が強かったといえるでしょう。その意味では1957年のスプートニク衛星と似ているかもしれません。大気圏外に到達した人類初の衛星でしたが、ラジオでその存在を主張する以外に実用的な機能はありませんでした。ですから、実用的な量子コンピューターがまだ存在しない限り、スーパーコンピューターがあらゆる科学分野で最も重要な役割を果たし続けます。量子コンピューティングの時代になったとしても、おそらく2種類のコンピューターが共存することになるでしょう。

量子コンピューティングの課題

量子コンピューターの開発は現代の研究と社会にさまざまな課題を突きつけています。一方は開発の技術的な実現可能性、もう一方はデジタル セキュリティへの世界的な影響です。

1.量子コンピューティングの技術的課題

科学者にとって最大の難関の1つは、まず量子コンピューターの演算能力を実用的または制御可能にするための基本的な技術的条件です。その理由は量子ビットの極めて高い感度にあります。外部からのちょっとした影響で特定の量子特性が失われてしまうのです。振動、磁界、電界、光、温度など外部からのさまざまな影響を受けるとエラーが発生し、演算プロセスが破壊されてしまいます。継続的に安定させるためには量子ビットをしっかり保護する必要がありますが、その一方で演算のために操作できるようにしておかなくてはなりません。円積問題のような難しさです。これを達成するため、たとえば量子ビットを絶対零度の–273.15°C近くまで冷却して超伝導状態にした上で外界から何重にも保護する方法があります。そうしたとしても、この種の量子ビットが安定するのはミリ秒単位です。このわずかな時間に演算を実行する必要があります。

一方、イオンなどの他の量子ビット技術はそれよりはるかに安定性が高く、その状態を数分、場合によっては数時間持続できますが、1つの演算ステップにかかる時間が長くなります。現在、以下を重点的に開発が進められています。

- エラーの影響の低減。多数の量子ビットを安定した「論理」量子ビットに集約する。

- 量子ビット数の大幅増加。ただし、それによってエラーの影響が増大する恐れもある。

もちろん、量子コンピューターに何かをさせるためのソフトウェアもまだ存在しません。量子コンピューターは現在のコンピューターとまったく異なる法則で機能するため、ソフトウェアにとってまったく新たな課題になっています。今のところ、量子アルゴリズム分野は見過ごされがちです。信じられないほど大量の状態で同時に演算できるという量子コンピューターが持つすばらしい能力を、理論を超えて現実に利用することはそれほど簡単ではありません。計算する目的は正しい結果を得ることにあります。しかし、量子コンピューターのすべての状態を読み出さなくてはならないなら、数が膨大なだけにこれは困難です。そのため、最も高い可能性を持つ正しい状態のみを演算の最終段階まで残すような独特のアルゴリズムが必要です。今のところ、これが実現できたのは限られた数の問題に対してのみです。

こうした課題が残っていることを考えると、量子コンピューターが日常生活に使われるようになるまでの道のりが長いのは明白です。

2.量子コンピューターが突きつけるデジタル セキュリティの課題

課題は量子コンピューターとそのアプリケーションの開発という技術的な難易度の高い基本要件だけではありません。量子コンピューターが大規模に利用できるようになった際、すぐに社会がその能力を受け入れる状態になっていなければなりません。なぜなら、暗号化、すなわちデジタル セキュリティの分野において、プライベートと仕事の両面で特別な問題が持ち上がる可能性があるからです。

「未来のデジタル ピッキング技術」――現在広く使用されている暗号システムを解読する能力を持つ量子コンピューターはこのような見出しを付けられるかもしれません。現在ネットサーフィンを行うための暗号化手法は将来的に量子コンピューターによる解読にも耐えられるよう強化しなければならなくなるでしょう。スーパーコンピューターの演算能力が向上している一方で、現代の暗号化手法は単に解読に数年の時間が必要であるという前提で安全性を保っているに過ぎないからです。

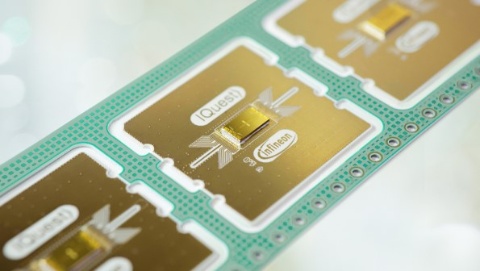

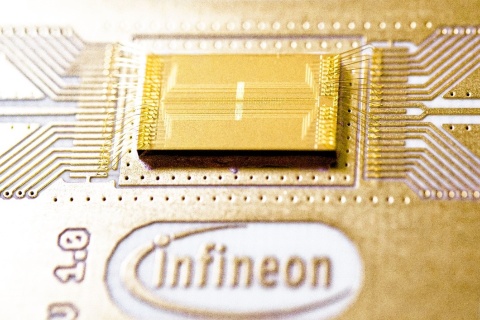

将来の量子コンピューターなら、古いシステムを解読できます。ただし、古いシステムが新しい暗号化手法に置き換えられないままであるという仮定での話です。そこで、ポスト量子暗号という、量子コンピューターに対しても安全な暗号化手法に関する研究が進められています。インフィニオンはその分野のパイオニアとして積極的にこの研究を進めています。詳しくはポスト量子暗号に関するインフィニオンの記事をご覧ください。

2014年のエドワード スノーデンの内部告発も注目の高さを示しています。米国国家安全保障局 (NSA) はすでに暗号分野における量子コンピューターの利用について精力的な研究を進めていたのです。そうした課題に対し、ポスト量子暗号はすでに初期段階のソリューションを提示し、成功を収めています。従来型コンピューターと同様、量子コンピューターを将来どのように発展させ、何に利用するかは私たち人間次第です。

個人ユーザー向けの量子コンピューターとは

量子コンピューターを購入できるようになるのはいつのことでしょうか。スマートフォンはさらにスマートになるのでしょうか。量子コンピューターの現状を見ると、画期的な発展が約束されているように思えますが、それは主に複雑な科学分野に限られます。なぜなら、量子コンピューターの運用とエラー対策機能に技術的努力が必要とされるからです。また、現在の知識で量子コンピューターがその大きな可能性をフルに利用できるのは特定の応用分野に限定されるからでもあります。そうしたことから、量子コンピューターが個人で利用できる未来はまだ漠然としています。

量子コンピューターと経済

金融セクター、物流、輸送プロセスから材料開発、複雑なシミュレーションに至るまで、量子コンピューターは革新的な発展を遂げる可能性を秘めています。すでにこのテクノロジーの商用化をめぐるレースが世界規模で展開しており、インフィニオンは初期からこの開発に貢献し、サポートしています。

特に力を入れているのは量子コンピューティング技術の拡張性で、それが未来のデジタル時代の実現に役立つはずです。チップ設計から材料、生産、ソフトウェアに至る関連分野のノウハウと能力を持つインフィニオンは量子コンピューティング開発をさらに進めていきます。量子コンピューティングを開発と基礎理論から商業的な関連アプリケーションに移行させるため、インフィニオンはQUTACの設立メンバーとしても活動しています。QUTACは量子コンピューティングを大規模産業アプリケーションのレベルにまで高め、商業的に成功するための独立した量子コンピューティング エコシステムの形成を促進する、ドイツのリーディング企業の連合です。

インフィニオンの技術的なサポートについて、詳しくは「Quantum computing – game changer for tomorrow (量子コンピューティング - 未来に向けたゲーム チェンジャー)」をご覧ください。